很多電影或運動拍攝,都會使用慢動作來加強畫面的感染力。以往拍攝者可能要利用高速攝影技術,在一秒間拍攝每秒 120 格甚至好似 Sony 的手機或相機那樣拍攝每秒 960 格的影片,然後以正常一秒 24~30格的速度來播放,這樣就可以有超順暢的慢動作片斷。不過如果大家是以正常速度拍攝的影片,要變成慢動作,又可以怎辦呢 ?

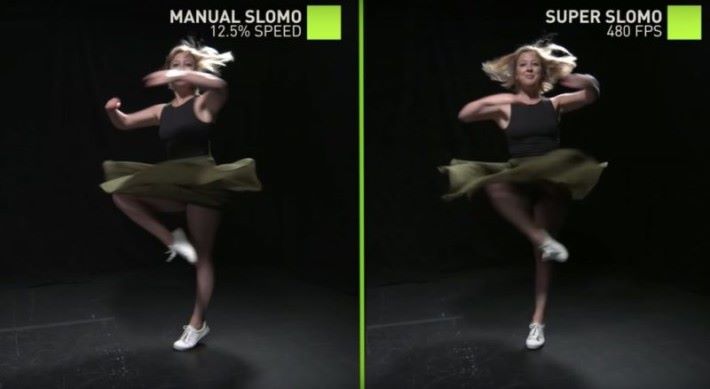

Nvidia 日前發表一條影片,內容是有關利用人工智能將普通影片轉為順暢自然的慢動作影片。以往我們嘗試將會一些以每秒 24 甚至 30格的影片,以 12.5% 速度拖慢成慢動作播放時,有明顯的卡頓。而利用人工智能轉換後的影片,影片會變成 240fps 效果播放,汽車飄移過程變得非常流暢。而除了順暢,觀眾對於影片的細節也很意,而利用人工智能轉換的女舞蹈家跳舞影片,可看到經轉換後的慢動作影片,人物旋轉時頭髮及衣裙等細節也能清晰看到。

[ot-video][/ot-video]

這個人工智慧主要由 Tesla V100 GPU 及 cuDNN 加速的 PyTorch 的 Deep Learning 框架組成,透過 1萬多段包括日常生活及體育活動的 240fps 影片,目前系統已經能夠將不同的正常速度影片轉換成慢動作。其實 Nvidia 亦展示過以人工智能,將白天變成黑夜,下雪變成晴天,還能改變動物斑紋,將美洲豹變成非洲獅。相信有關的技術正式推出後,會對於電影後期製作甚至影片修復工作會有莫大的幫助。